چطور از هوش مصنوعی بد استفاده نکنیم؟

هوش مصنوعی این روزها همهجا هست و هر روز ایدههای جدیدی برای به کار گرفتن آن مطرح میشود. ابزارهای تولید متن مبتنی بر هوش مصنوعی مثل ChatGPT و موارد مشابه، واقعاً تحسینبرانگیزند، اما خیلی راحت میتوان در مورد کارایی و تواناییهایشان اغراق کرد. در شبکههای اجتماعی و وبلاگها، پیشنهادهای زیادی میبینیم که در ظاهر درست به نظر میرسند اما در عمل کار نمیکنند. بنابراین، اگر قصد دارید ابزارهای تولید محتوای هوشمند را به چرخه کاری خود اضافه کنید، چند نکته مهم وجود دارد که باید در نظر داشته باشید.

در این مطلب، ما از چت جی پی تی به عنوان نمونه استفاده میکنیم، اما این نکات در مورد هر ابزار تولید متن دیگری هم صدق میکند. بیشتر این ابزارها از موتور زبان مشابهی به نام GPT-4 استفاده میکنند. هرچند GPT-5 هم عرضه شده، اما هنوز به طور گسترده در دسترس نیست و هزینه بیشتری دارد. پس بیایید ببینیم چطور میتوانیم از اشتباهات رایج در استفاده از هوش مصنوعی دوری کنیم.

سازوکار ابزارهای تولید متن با هوش مصنوعی چگونه است؟

دلیل اصلی که هوش مصنوعی مولد هنوز کاملاً قابل اعتماد نیست، این است که در واقع به شما «اطلاعات» نمیدهد، بلکه «کلمات» را کنار هم میچیند. وقتی شما یک درخواست (Prompt) به آن میدهید، ابزار با توجه به دادههای آموزشی وسیع خود، متنی را تولید میکند که از نظر آماری محتملترین پاسخ به نظر میرسد.

اینکه مدلهای زبانی در پیشبینی کلمه بعدی و ساختن جملات دستوری درست مهارت دارند، به این معنی نیست که میتوانند محدودیتهای اطلاعاتی که با آن آموزش دیدهاند را دور بزنند. همین موضوع باعث بروز مشکلاتی مثل سوگیریهای مختلف شده و به همین دلیل است که باید در شرایط خاص، در استفاده از هوش مصنوعی و اعتماد به آن محتاط باشیم.

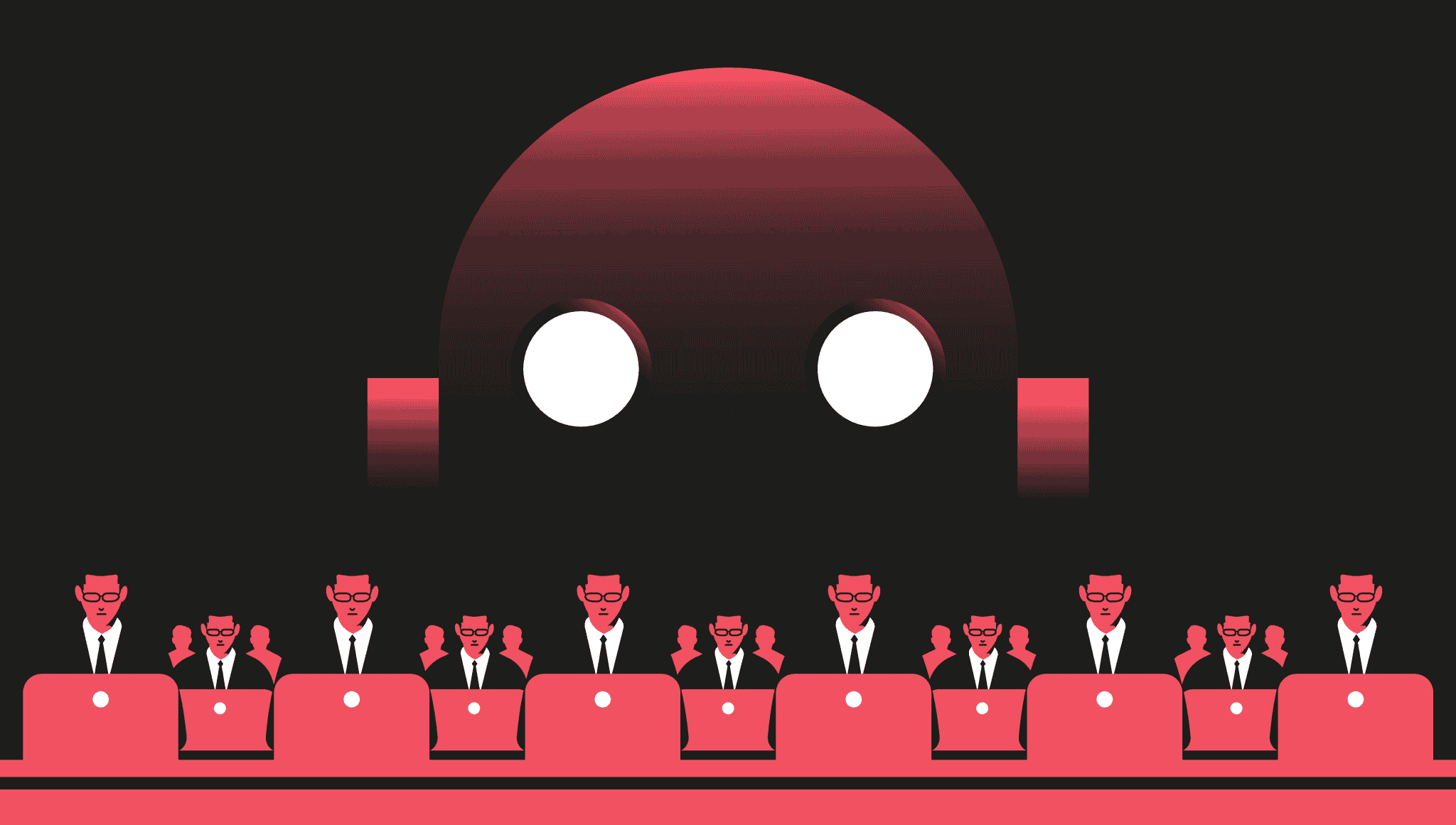

اشتباه اول: رها کردن هوش مصنوعی بدون نظارت

بزرگترین چالش در مورد ابزارهای مبتنی بر GPT این است که تقریباً هر چیزی که میگویند، بسیار «باورپذیر» به نظر میرسد. این یک ویژگی مثبت است، اما اغلب میتواند یک باگ بزرگ هم باشد.

یک شرکت بزرگ فناوری در دموی محصول جدید خود این مشکل را به خوبی نشان داد. یکی از درخواستها این بود: «چه اکتشافات جدیدی از تلسکوپ فضایی جیمز وب را میتوانم برای کودک ۹ سالهام تعریف کنم؟» هوش مصنوعی در پاسخ گفت: «تلسکوپ جیمز وب اولین تصاویر از سیارهای خارج از منظومه شمسی ما را گرفت.» این جمله کاملاً منطقی به نظر میرسد، اما واقعیت ندارد. اولین تصویر از این نوع در سال ۲۰۰۴ توسط تلسکوپ بسیار بزرگ رصدخانه جنوبی اروپا (VLT) گرفته شده بود.

اوضاع برای یک وبسایت خبری حوزه فناوری حتی بدتر هم شد. از ۷۷ مقالهای که در حوزه مالی با کمک هوش مصنوعی منتشر کرده بود، مجبور شد برای ۴۱ مورد از آنها اصلاحیه صادر کند! این مقالات شامل موضوعات پایهای مانند «سود مرکب چیست؟» بودند. ظاهراً قرار بود این مقالات توسط تیم تحریریه بازبینی و راستیآزمایی شوند، اما واضح است که این اتفاق نیفتاده بود.

این مثالها در حوزه بازاریابی هم دیده میشود. اگر هر چیزی که رباتها تولید میکنند را بدون بررسی منتشر کنید، به احتمال زیاد با خطاهای واقعیتی مواجه خواهید شد. این موضوع به خصوص زمانی اهمیت دارد که در مورد یک محصول یا سرویس جدید مینویسید که در دادههای آموزشی هوش مصنوعی وجود ندارد. برای مثال، هوش مصنوعی بینگ در زمان معرفی ادعا کرد که یک جاروبرقی حیوانات خانگی، سیمی به طول ۱۶ فوت دارد، در حالی که آن مدل یک جاروی دستی و بیسیم بود!

اگر از آن بخواهید محصول شما را توصیف کند، انتظار داشته باشید که ویژگیهای باورپذیر اما کاملاً ساختگی برای آن بتراشد. این پدیده به «توهم» (Hallucination) در هوش مصنوعی معروف است. بنابراین، هرگز استفاده از هوش مصنوعی را بدون نظارت رها نکنید.

اشتباه دوم: اعتماد بیش از حد به عنوان ابزار تحقیق

از همان ابتدا، ابزارهای گفتگو محور به عنوان جایگزینی برای موتورهای جستجو معرفی شدند. پاسخهای خلاصه، منسجم و بدون تبلیغات آنها جذاب است. اما این ابزارها هر پاسخی را با قطعیت و اقتدار کامل ارائه میدهند و خیلی راحت میتوان قانع شد که حرفشان درست است، حتی وقتی که اینطور نیست.

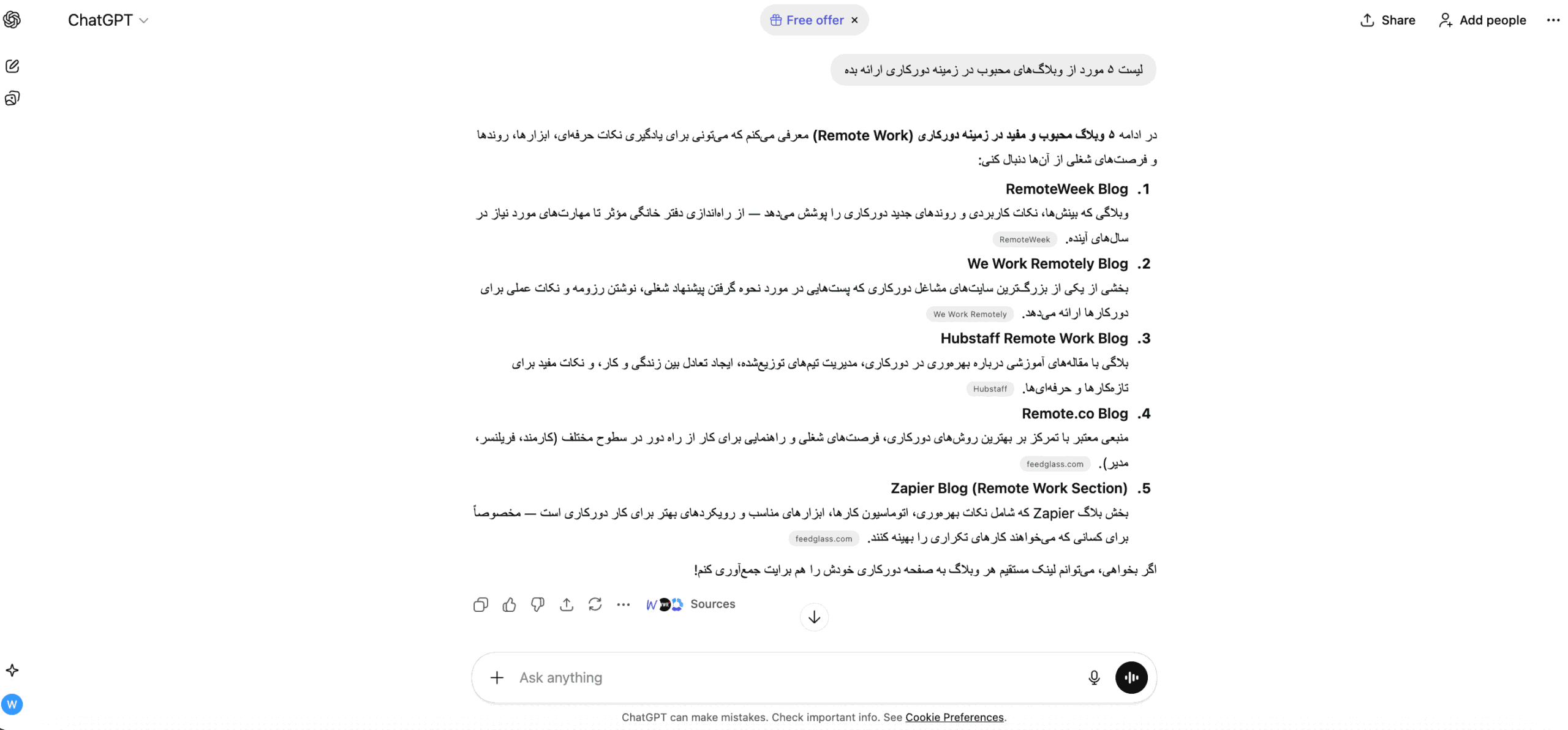

برای مثال، وقتی از ChatGPT خواسته شد لیستی از وبلاگهای محبوب در زمینه دورکاری ارائه دهد، نتایج افتضاح بود. از پنج پیشنهاد، سه لینک خراب بود، یکی سایت یک فالگیر بود و دیگری یک سایت کاریابی. در تست بعدی با مدل GPT-4، نتایج کمی بهتر شد، اما هنوز مشکلات زیادی وجود داشت.

حتی با مدل پیشرفتهتر GPT-5، نتایج همچنان ترکیبی از خوب و بد بود. این بار لیست شامل دو سایت کاریابی بود! جالب اینکه خود هوش مصنوعی در انتها پیشنهاد کرد که برای نتایج بهتر از گوگل استفاده کنید.

در آزمایشی دیگر، وقتی از مدل GPT-3 میانگین بارش در دوبلین طی ماههای ژوئن، ژوئیه و آگوست پرسیده شد، اعدادی نزدیک به مقادیر رسمی ارائه داد، اما همچنان اشتباه بودند. این اطلاعاتی است که با یک جستجوی ساده در گوگل به راحتی پیدا میشود، اما هوش مصنوعی با اطمینان پاسخ غلط میدهد.

جالب اینجاست که مدل GPT-4 در مواجهه با همین سوال، رویکرد متفاوتی در پیش گرفت: از پاسخ دادن امتناع کرد و توصیه کرد که به سرویس هواشناسی محلی مراجعه شود. این نشان میدهد که مدلهای جدیدتر از محدودیتهای خود آگاهتر شدهاند. همه اینها ثابت میکند که استفاده از هوش مصنوعی هنوز جایگزین ابزارهای تحقیق موجود نیست.

اشتباه سوم: پنهان کردن استفاده از هوش مصنوعی

این مورد بیشتر یک دغدغه اخلاقی است. هیجانزدگی در مورد آینده ابزارهای هوشمند طبیعی است، اما اینکه بدون اطلاع دادن به مشتریان، کارفرمایان یا مخاطبان خود به طور کامل به هوش مصنوعی تکیه کنید، کار درستی نیست.

شفافیت کلید اصلی است. اگر قرار است برای چیزی فراتر از کارهای ساده و سرگرمی از این ابزارها استفاده کنید، حتماً این موضوع را به طور شفاف اعلام کنید. در غیر این صورت، همانطور که برای آن وبسایت خبری اتفاق افتاد، ممکن است با عواقب ناخوشایندی روبرو شوید و اعتبار خود را از دست بدهید.

پس روش هوشمندانه برای استفاده از هوش مصنوعی چیست؟

در حال حاضر، ما در یک نقطه عطف قرار داریم. هوش مصنوعی قطعاً بخش مهمی از آینده کاری ما خواهد بود، اما چگونگی آن هنوز مشخص نیست. ابزارهای مبتنی بر GPT نباید به حال خود رها شوند. این یعنی آنها بیشتر برای سرعت بخشیدن به کارهای ساده مفید هستند تا انجام مستقل وظایف.

با در نظر گرفتن این موضوع، در اینجا چند روش هوشمندانه برای استفاده از هوش مصنوعی آورده شده است:

- جرقه زدن برای ایدههای محتوایی

- نوشتن پیشنویس ایمیلهای کاری

- الهام گرفتن برای متنهای تبلیغاتی و بازاریابی

- خلاصه کردن صورتجلسات و گفتگوها

- کمک به تعریف معیارهای پذیرش در پروژههای نرمافزاری

- تحلیل اولیه سرنخهای فروش (Leads)

در نهایت، کلید موفقیت در استفاده از هوش مصنوعی، درک محدودیتهای آن و بهرهبرداری از نقاط قوتش است. آن را به عنوان یک کمکخلبان هوشمند ببینید، نه یک خلبان خودکار. با نظارت انسانی، راستیآزمایی و شفافیت اخلاقی، میتوانید از این فناوری به بهترین شکل ممکن بهرهمند شوید.

-

Telegram

-

Twitter

-

Whatsapp

-

Linkedin

-

Facebook